A Wide Labs, uma empresa de tecnologia de Porto Alegre, disse que desenvolveu um large language model (LLM), um dos primeiros nativos em português brasileiro.

O modelo – batizado de Amazônia IA – será apresentado amanhã, em Brasília, durante a Conferência Nacional de Ciência, Tecnologia e Inovação. O evento será o palco para o Presidente Lula lançar um plano nacional para incentivar o desenvolvimento de inteligência artificial.

A Wide Labs não abriu dados técnicos sobre o modelo – como por exemplo o número de parâmetros usados para treiná-lo – mas afirma se tratar de uma linguagem robusta, ou seja, capaz de entregar resultados com elevado grau de precisão.

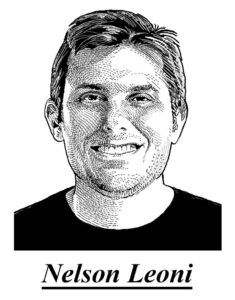

“É ciência brasileira na veia,” disse Nelson Leoni, o CEO da Wide Labs. “Nascemos no Brasil, tomando todos os cuidados de segurança e respeitando as regras de uso de informação.”

A Wide Labs tem como parceiras no desenvolvimento a Nvidia e a Oracle.

A empresa vinha desenvolvendo soluções em IA a partir dos LLMs das grandes empresas dos EUA, mas desde o início ambicionava desenvolver um modelo proprietário.

A Amazônia vai rodar em dois data centers da Oracle, ambos localizados no Brasil. Como no caso das Big Techs, haverá um bot conversacional gratuito e, na sequência, serviços premium pagos.

“Vamos cobrar em reais, e não em dólares, e os preços serão consideravelmente menores do que os das Big Techs,” disse Leoni, um empreendedor na área de marketing digital com passagem pelo BTG e um oficial reformado do Exército. Aluno da Academia Militar das Agulhas Negras, Leoni deixou as Forças Armadas depois de ser ferido em combate quando serviu na Missão de Paz da ONU no Haiti.

A Amazônia IA será uma vertical de negócios dentro da Wide Labs, mas poderá ganhar vida própria. Na disputa de mercado com as estrangeiras, seus executivos acreditam que, além de preço, o “viés brasileiro” da IA poderá jogar a favor.

Vastos datasets de fontes nacionais, incluindo institutos de pesquisas e universidades, foram usados no treinamento do modelo. O LLM foi concebido dentro das regulamentações internacionais existentes e alinhado à Lei Geral de Proteção de Dados.

A previsão é lançar em breve modelos menores, de usos mais específicos, por exemplo dedicados à área jurídica, à comunicação ou aplicações médicas.

O CIO da Wide Labs é Marcelo Chapper, um médico com mestrado em economia comportamental e especialista em tecnologia criativa. Rodrigo Malossi, o CTO, é engenheiro de software e doutor em física comportamental (sim, isto existe).

Entre outros projetos, a Wide Labs ganhou projeção com o bAIgrapher, segundo a empresa o primeiro biógrafo de inteligência artificial do mundo. A concepção inovadora ajuda pacientes de Alzheimer a preservar funções cognitivas, retardando a evolução da doença.

Recordações da pessoa e de seus familiares – seja depoimentos, vídeos e imagens – são processadas pelo ‘biógrafo’ de IA, que ‘cria’ memórias em uma forma automatizada. Ainda em fase experimental, o bAIgrapher conquistou uma série de prêmios internacionais, incluindo em Leão de Bronze em Cannes no ano passado.

A Amazônia não está sozinha no desenvolvimento de um LLM nativo.

A Maritaca AI, fundada em 2022, também já havia desenvolvido um ‘ChatGPT’ brasileiro, a MariTalk.

A startup foi criada pelo engenheiro e cientista de computação Rodrigo Nogueira ao lado de colegas pesquisadores do núcleo de estudos em inteligência artificial da Unicamp. Contou no início com apoio do Google e recentemente recebeu o aporte de um investidor.

No início, a startup usava como base os modelos pré-treinados vindos de fora. Mas as versões mais recentes do Sabiá, o seu sistema de linguagem, são totalmente proprietárias, criadas e treinadas no Brasil.

“Quanto mais o modelo for treinado no Brasil, com datasets brasileiros, mais útil e preciso será para dar respostas às necessidades dos brasileiros,” afirmou Rodrigo.

Isso significa, por exemplo, auxiliar as pessoas a fazer uma reclamação ao Procon, preencher a declaração do Imposto de Renda e avaliar as opções de investimentos oferecidas pelos bancos locais.

“Vejo um futuro com briga das IAs, uma competindo com as outras,” disse Rodrigo. “As empresas estão investindo muito para desenvolver recursos e aplicações, mas não vejo tanta atenção em criar ferramentas de defesa dos consumidores.”

Em sua opinião, há dois grandes obstáculos para o desenvolvimento de inteligência artificial nativa no Brasil: a falta de gente qualificada – ainda são poucos os que entendem “de fato” desse tipo de programação – e a limitação na capacidade de processamento de dados.

“Capacidade de computação é o grande gargalo,” afirmou.

Com relação a esse aspecto, um dos pontos da política de inteligência artificial a serem apresentados amanhã pelo Governo será a construção de um supercomputador que poderá ser usado pelos pesquisadores brasileiros.

O posto IAs brasileiras começam a nascer. Capacidade de computação é o grande gargalo apareceu primeiro em Brazil Journal.